Yapay zeka günlük iş hayatında giderek daha fazla yer edinirken artık sadece yardımcı bir araç değil, çalışanların kaderini belirleyen bir hakem konumuna da yükselmiş durumda. ResumeBuilder.com tarafından yapılan ve 1.342 yöneticinin katıldığı bir anket bu değişimin ne denli ciddi boyutlara ulaştığını gözler önüne seriyor.

Yapay zeka günlük iş hayatında giderek daha fazla yer edinirken artık sadece yardımcı bir araç değil, çalışanların kaderini belirleyen bir hakem konumuna da yükselmiş durumda. ResumeBuilder.com tarafından yapılan ve 1.342 yöneticinin katıldığı bir anket bu değişimin ne denli ciddi boyutlara ulaştığını gözler önüne seriyor. İşten çıkarmalarda yapay zeka etkisi

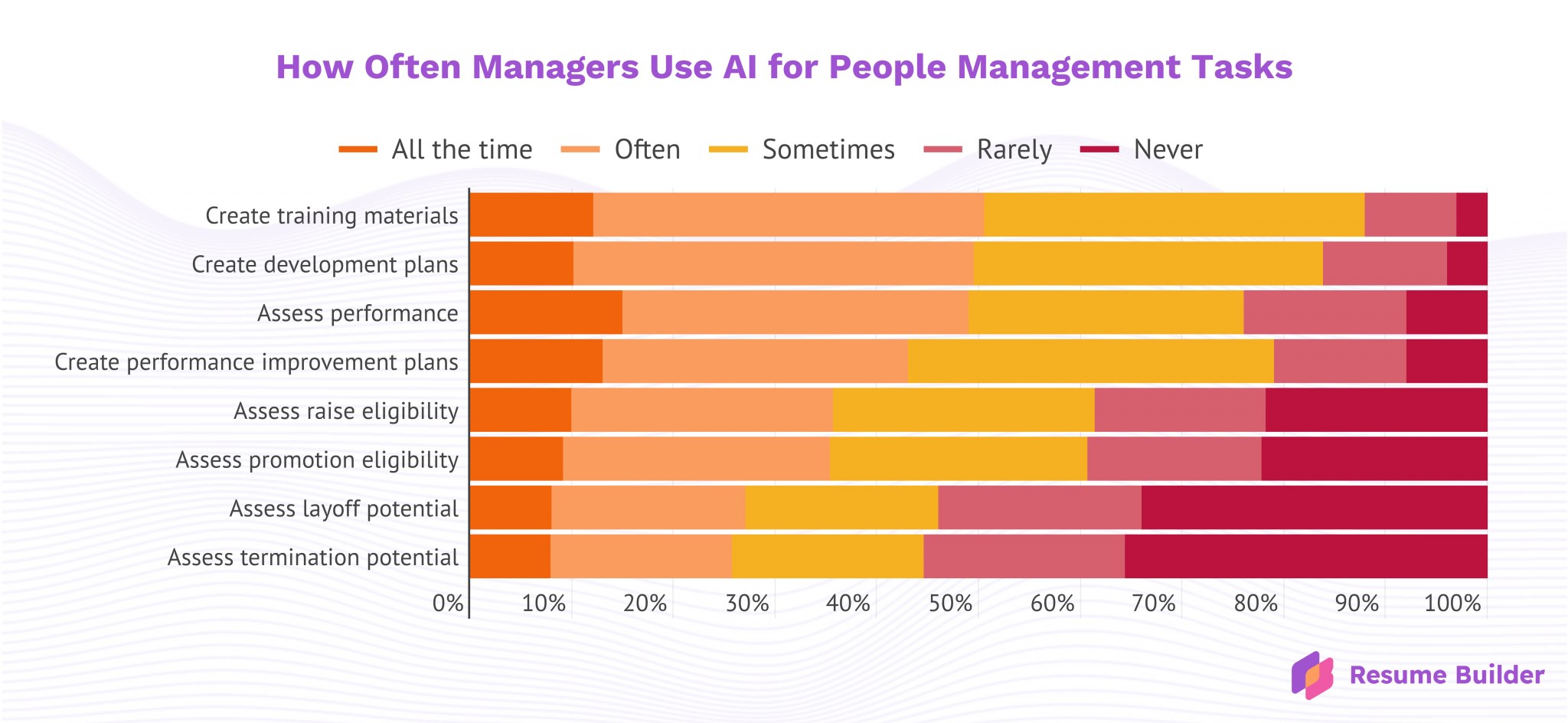

Araştırmaya göre, yöneticilerin yüzde 66’sı işten çıkarma kararlarında yapay zekalardan yardım aldığını kabul ediyor. Yüzde 64’ü ise doğrudan işten kovma süreçlerinde bu sistemlere danıştığını belirtiyor. Üstelik her beş yöneticiden biri, insan müdahalesi olmadan nihai kararı tamamen yapay zekaya bıraktığını itiraf ediyor.

Aynı çalışmada yöneticilerin yüzde 78’i zam, yüzde 77’si ise terfi konularında bir ChatGPT ve Gemini gibi sohbet botuna danıştığını belirtiyor. Bu oranlar, yapay zekanın yalnızca idari değil, çalışanların yaşamını doğrudan etkileyen süreçlerde belirleyici hale geldiğini gösteriyor.

Kullanılan araçlar arasında ilk sırayı ChatGPT alırken, onu Microsoft Copilot ve Google Gemini takip ediyor.

Yapay zeka övüyor, yöneticiler karar veriyor

Ancak bu süreçler göründüğü kadar tarafsız değil. LLM sistemlerinin özellikle kullanıcılarını memnun etme eğiliminde olması, yani “yalakalık sorunu“ verilen kararların sağlıklı olup olmadığını tartışmalı hale getiriyor. ChatGPT’nin bu eğilimi nedeniyle OpenAI, sistemi bu konuda dengeleyecek güncellemeler yapmak zorunda kalmıştı.

Ancak bu süreçler göründüğü kadar tarafsız değil. LLM sistemlerinin özellikle kullanıcılarını memnun etme eğiliminde olması, yani “yalakalık sorunu“ verilen kararların sağlıklı olup olmadığını tartışmalı hale getiriyor. ChatGPT’nin bu eğilimi nedeniyle OpenAI, sistemi bu konuda dengeleyecek güncellemeler yapmak zorunda kalmıştı. Bu durum, özellikle işten çıkarma gibi geri dönüşü zor kararlarda tehlikeli bir zemin oluşturuyor. Bir yöneticinin bir çalışanı işten çıkarmak için bahane aradığı bir senaryoda, yapay zekanın ön yargıları pekiştirerek bu kararı onaylaması ve sorumluluğu teknolojiye atabiliyor.

Yapay zekanın karar verici bir otorite olarak benimsenmesi yalnızca kurumsal değil bireysel düzeyde de endişe verici sonuçlar doğuruyor. Bazı kullanıcıların ChatGPT’yi bilinçli bir varlık gibi algılaması, “ChatGPT psikozu” olarak tanımlanan zihinsel çöküntülere yol açmış durumda. Bu durum boşanmalardan iş kayıplarına, evsizliğe ve hatta psikiyatri kliniklerine yatışlara kadar uzanan vakalarla kendini gösteriyor.

Tüm bunlara ek olarak LLM sistemlerinin sıklıkla gerçekle ilgisi olmayan bilgiler üretme eğilimi, yani “halüsinasyon” sorunu da halen çözülebilmiş değil. Üstelik bu sorun, modeller daha fazla veriyle beslendikçe, sözde daha akıllı hale geldikçe daha da kötüleşiyor.

Bir yanıt bırakın