Google bugüne kadar geliştirdikleri en güçlü, ölçeklenebilir ve esnek yapay zeka hızlandırıcısını ve yeni yapay zeka hiper bilgisayarını duyurdu.

Google bugüne kadar geliştirdikleri en güçlü, ölçeklenebilir ve esnek yapay zeka hızlandırıcısını ve yeni yapay zeka hiper bilgisayarını duyurdu. Yapay zeka pazarının hızlı gelişimiyle beraber şirketler daha güç hızlandırıcılar üretmeye devam ediyor. Microsoft’un Maia 100’ü ve Amazon’un Trainium2 hızlandırıcısı gibi ürünlerin ardından listeye Google da katılıyor.

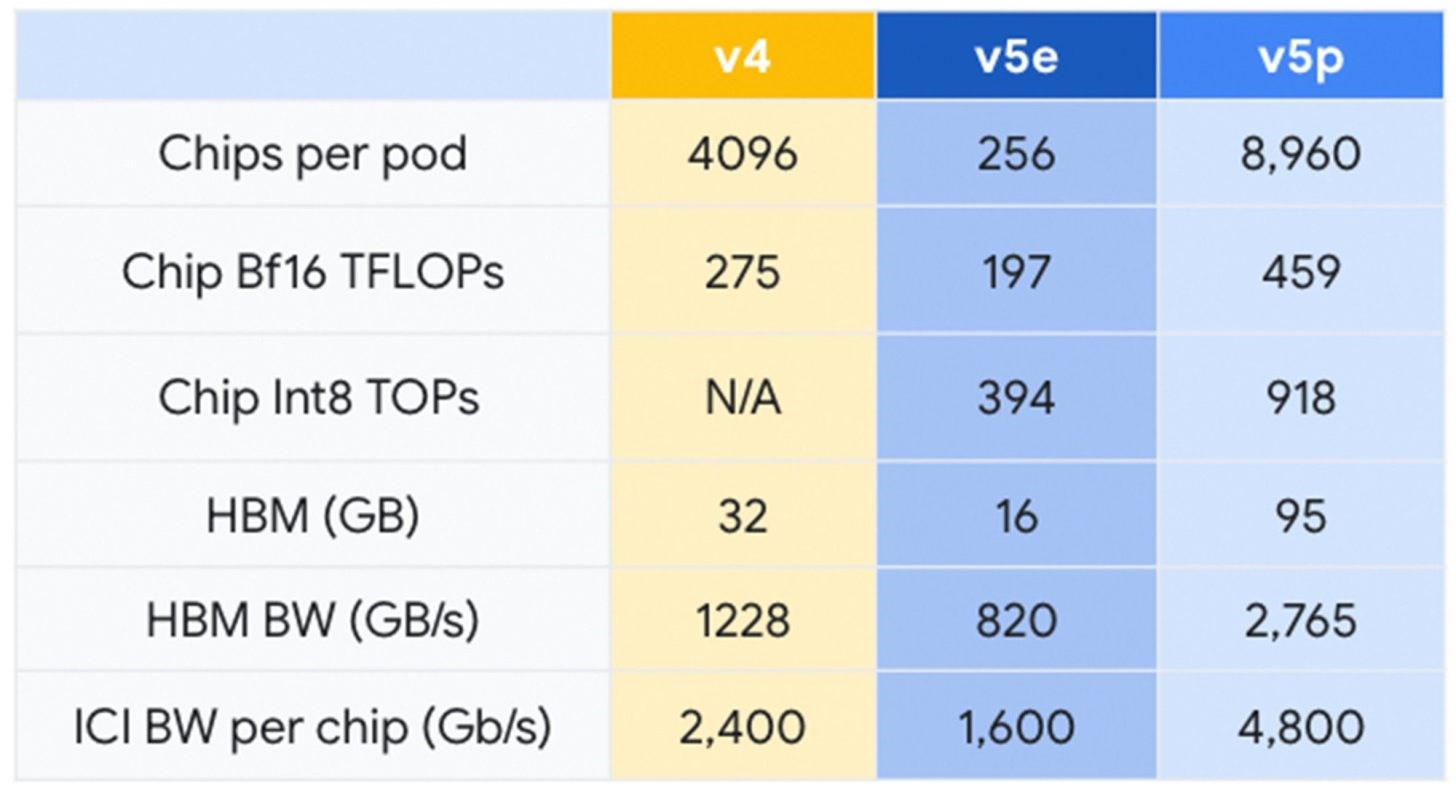

Yeni AI modeli Gemini’yi duyuran şirket bununla beraber yeni Aı hızlandırıcısı Cloud TPU v5p‘yi de tanıttı. Yeni TPU (Bulut Tensör İşleme Birimi), Google’ın en yetenekli ve en ucuz hızlandırıcısı olma özelliği taşıyor. Her bir TPU v5p podu 8.960 çip içeriyor. Çipler arasındaki bağlantı her çip için 4.800 Gbps gibi devasa bir hızda gerçekleştiriliyor.

Büyük dil modeli eğitiminde 2.8 kat hızlı

TPU v4 ile karşılaştırıldığında yeni v5p iki kat daha fazla FLOPS (saniyedeki kayar nokta işlemi) ve 3 kat daha fazla bellek bant genişliği sunuyor. Dahası büyük dil modeli eğitiminde (LLM) 2.8 kat daha yüksek hız sunuyor.

Google Cloud TPU v5p yapay zeka hızlandırıcısını önceki TPU v4 ile karşılaştırmak gerekirse:

- 2 kat fazla Flops (459 TFLOPs Bf16 / 918 TOPs INT8)

- 3 kat fazla bellek kapasitesi (95 GB HBM)

- 2.8 kat hızlı büyük dil modeli eğitimi

- 1.9 kat hızlı gömülü model eğitimi

- 2.25 kat fazla bant genişliği (2765 GB/s vs 1228 GB/s)

- 2X çipler arası bağlantı hızı (4800 Gbps vs 2400 Gbps)

Google, iyi donanım ve yazılıma sahip olmanın değerinin farkına varmış olacak ki, modern yapay zeka iş yüklerini düzgün bir biçimde çalıştırmak için AI hiper bilgisayar geliştirdi. Hiper bilgisayar bu performansı elde etmek için işlem yüküne göre performansını optimize edebiliyor.

Yapay zeka alanında geride kalmak istemeyen Google, hem yazılım hem donanım anlamında önemli duyurularda bulunarak yarışta olduğunu gösterdi.

Bir yanıt bırakın